GPT-3, après 6PO et R2D2 dans Star Wars, la famille des IA au nom de code barbare vient de s’agrandir. GPT-3 (Generative Pre-training) cette intelligence artificielle développée par la société OpenAI (fondée par Elon Musk, encore lui!) est l’innovation de l’année en termes d’IA. Elle écrit des textes complets « à la manière de » difficile à distinguer d’un article créé par un humain. Elle écrira mails et courriers à votre place. Bouleversement en vue dans les métiers de la communication, de la création et du développement informatique! En 2019, nous avions consacré un article à Project Debater l’IA d’IBM qui débat avec les humains. GPT-3 va encore plus loin, un pas de géant pour ce que les spécialistes appellent le NLP et le NLG (natural language processing & generation). Mais cette percée en matière de data science est-elle véritablement une étape vers une IA forte capable d’égaler le cerveau humain?

Le Guardian publie un article entièrement écrit par GPT-3

8 septembre 2020, le Guardian publie un article écrit à la 1ère personne par quelqu’un qui se présente comme une intelligence artificielle. Elle explique pourquoi les hommes ne devraient pas avoir peur de l’intelligence artificielle. Le propos n’est pas d’une énorme créativité mais l’article est bien structuré et bien argumenté. Il n’aurait pas fait tâche dans les pages « Opinion » de n’importe quel journal.

L’originalité de cet article est qu’il a effectivement été écrit par une intelligence artificielle, en l’occurrence GPT-3 la nouvelle IA développée par la société OpenAI sortie dans sa version bêta au mois de juillet. Le résultat est bluffant.

A l’heure du big data, avec les techniques de NLG (natural language generation) utilisant les algorithmes de deep learning (réseau de neurones artificiels), on savait l’IA capable d’écrire des articles, du reporting, de commenter un match de foot ou de répondre à des questions dans un chatbot. L’IA traduit déjà des textes avec précision comme l’incroyable Google Translate. Une IA a déjà battu l’homme au jeu de questions Jeopardy.

Mais GPT-3 va beaucoup plus loin. Il peut faire tout cela à la fois, non pas sur un sujet spécialisé mais sur tous les sujets. Il peut écrire à la manière de Shakespeare comme il peut « traduire » un texte juridique en un langage intelligible.

OpenAI à l’origine un centre de recherche & développement sur l’intelligence artificielle humaniste à but non lucratif

En 2015, Elon Musk le sulfureux patron de Tesla et Space X crée OpenAI en association avec plusieurs stars fortunées de la Silicon Valley (Peter Thiel rencontré dans l’aventure Paypal, Reid Hoffman un des fondateurs de Linkedin, Sam Altman…). Elon Musk n’a jamais caché sa crainte que l’IA finisse par se retourner contre l’homme déclarant : « le rythme de progression des ordinateurs est fou….elles finiront par considérer les humains comme des êtres lents et stupides ». L’ambition d’OpenAI est a contrario de créer un centre de recherche et développement en intelligence artificielle à but non lucratif avec une mission humaniste : « faire en sorte que l’intelligence artificielle générale profite à toute l’humanité. »

Les bonnes fées fondatrices dotent ce nouveau centre de R&D d’un budget de 1 milliard de dollars. Ce budget permet de débaucher à prix d’or les meilleurs experts du marché dont Ilya Sutskever venu de chez Google. OpenAI s’engage alors à partager très largement le fruit de leurs recherches dans une logique proche de l’open source « Etant à but non lucratif, notre but est de créer de la valeur pour tous et non pas pour nos actionnaires. Les chercheurs seront fortement encouragés à publier leur travail, ainsi que leurs articles, billets de blog ou code, et si nous déposons des brevets, ils seront partagés avec le monde. »

Les modèles GP-T révolutionnent les modèles d’intelligence artificielle

OpenAI se focalise sur les modèles de machine learning (apprentissage automatique) autour du langage NLP natural language processing (traitement du langage ) et NLG natural language generation (génération de langage). Ces modèles ont fait ces dernières années d’énormes avancées notamment sous l’impulsion de Google. OpenAI sort GPT-1 en juin en 2018, suivi par GPT-2 début 2019.

L’idée centrale du « Generative Pre-training » est de pouvoir pré-entraîner l’intelligence artificielle de manière non supervisée sur une grande quantité de données. Les modèles GP-T apprennent donc sans avoir besoin « d’étiqueter » une grande quantité de données. Dans un autre domaine de l’IA : la reconnaissance d’image, on estime qu’il faut 100.000 images de chats étiquetées pour que l’IA fasse une bonne prédiction et reconnaisse un chat. Cette tâche est souvent fastidieuse réalisée par les crowdworkers ces nouveaux « travailleurs du clic ». Pouvoir largement s’en passer est donc une avancée majeure.

Les résultats de GPT-2 sont d’ailleurs déjà spectaculaires à tel point qu’OpenAI refuse pendant 6 mois d’en publier le modèle par crainte d’abus potentiels notamment la création massive de fake news, de spams ou de campagne de désinformation. Pendant ce temps, les ingénieurs d’OpenAI travaillent d’arrache-pied

GPT-3 un gigantesque modèle utilisant 175 milliards de paramètres

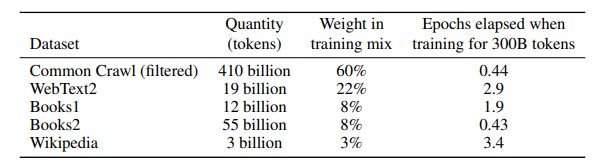

Fin mai 2020, OpenAI annonce la sortie prochaine de GPT-3 sa nouvelle intelligence artificielle. Gigantisme est le mot qui la caractérise. Pour son apprentissage, l’algorithme de GPT-3 a ingurgité 500 milliards d’expressions. L’IA a bien sûr parcouru l’intégralité de Wikipédia en anglais mais avec 3 milliards d’expression, Wikipédia ne représente que 0.6% de son apprentissage. L’essentiel provient de Common Crawl une gigantesque base de données qui archive toutes les données du Web depuis 2011. En fait GPT-3 a en quelque sorte « appris » tout le web anglophone.

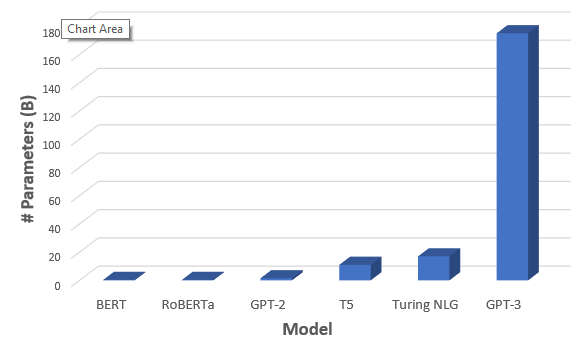

Le réseau de neurones artificiel de GPT-3 compte 175 milliards de paramètres. C’est du jamais vu pour ce type de modèle. Le record était jusqu’à présent détenu par le Turing-NLG de Microsoft avec 17 milliards de paramètres. GPT-2 utilisait lui « seulement » 1.5 milliards de paramètres.

Pour faire tourner GPT-3, Microsoft a construit pour OpenAI l’un des 5 plus gros supercalculateurs au monde : 285.000 CPU cores, 10.000 GPU de la société NVidia et 400 gigabits par seconde. L’entraînement de GPT-3 aura nécessité une capacité de 36400 petaflop/s-day (1 petaflop/s-day équivaut à l’efficacité complète 8 V100 GPU pendant 1 journée). Les spécialistes apprécieront.

Des applications multiples de GPT-3 qui vont bouleverser les métiers de la création et de la communication

A la sortie de GPT-3, OpenAI joue l’effet rareté. L’API en version bêta est distribuée au compte-goutte à quelques développeurs triés pour le volet. GPT-3 est lancé comme un nouvel Iphone ou un produit de luxe. Il faut qu’on se l’arrache.

Alors bien sûr, les heureux privilégiés qui ont accès à l’API GPT-3 s’en donnent à cœur joie pour la tester et inventer de nouveaux cas d’usage. GPT-3 fait le buzz quotidiennement sur Twitter avec de nouvelles applications. Si GPT-3 parle essentiellement anglais, elle sait aussi parler dans les principaux langages informatiques HTML/CSS, JSX ou Python. GPT-3 permettra donc d’écrire des textes mais aussi de programmer des applications informatiques complètes en utilisant du langage naturel sans avoir à coder. Il peut aussi compléter des tableurs Excel. Sa petite sœur DALL.E à qui nous avons consacré un autre article crée des images à partir de texte.

Mais plus qu’un grand discours, j’ai sélectionné ci-dessous 2 vidéos de démo qui vous présentent les possibilités de GPT-3.

GPT-3 un énorme business en perspective, OpenAI dit adieu au modèle à but non lucratif

En mars 2019, quelques mois après la sortie de GPT-2, OpenAI annonce la création de OpenAI LP (Limited Profit) une société hybride entre un modèle purement à but lucratif et une société à but non lucratif.

Les développements d’OpenAI sont prometteurs, les perspectives de business aussi. Mais OpenAI doit faire face aux mastodontes Google, Amazon, Facebook, IBM Watson qui investissent des milliards de dollars dans l’IA. La bataille pour fidéliser les meilleurs chercheurs est féroce. Dans la course à l’IA générale ou IA forte, les projets d’IA géante comme GPT-3 demandent d’énormes investissements. Ilya Sutskever le directeur scientifique d’OpenAI déclare : « il n’y a aucun moyen de rester à la pointe de la recherche en IA, sans augmenter massivement notre investissement informatique ». OpenAI est rattrapé par la logique du capitalisme de la Silicon Valley. Elle doit dire adieu au modèle non lucratif imaginé par ses fondateurs. L’utopie humaniste des fondateurs aura tenu 3 ans.

Rapprochement stratégique avec Microsoft qui obtient la licence exclusive pour GPT-3

Quelques mois plus tard en juillet 2019, Microsoft annonce un investissement d’1 milliard de dollars dans OpenAI combiné à un partenariat technologique mettant à disposition d’OpenAI sa plate-forme Azure de Cloud Computing. Objectif affiché du partenariat : aller ensemble vers l’IA forte ou IA générale. Dans la foulée, Microsoft construit également pour GPT-3 le supercalculateur évoqué précédemment.

C’est donc sans surprise que OpenAI annonce en septembre 2020 avoir accordé une licence exclusive de GPT-3 à Microsoft. Les utilisateurs continueront à pouvoir accéder à GPT-3 via son API mais seul Microsoft pourra intégrer GPT-3 dans ses propres produits ce qui offre des opportunités commerciales exceptionnelles au créateur de Word, Excel et Powerpoint.

Cet accord fait grincer des dents. Elon Musk (qui a quitté le conseil d’administration d’OpenAI en 2018 pour éviter des conflits d’intérêt) fait part publiquement de son désaccord. Il déclare sur Twitter « cela semble exactement le contraire d’être ouvert. OpenAIa été pour l’essentiel capturée par Microsoft ».

Mais si l’esprit d’origine à but non lucratif d’OpenAI semble bien s’être perdu dans les milliards de la Silicon Valley, sa finalité d’inventer une IA forte demeure. Mais GPT-3 constitue-t-il un pas décisif en la matière?

This does seem like the opposite of open. OpenAI is essentially captured by Microsoft.

— Elon Musk (@elonmusk) September 24, 2020

GPT-3 un pas majeur vers l’intelligence artificielle forte?

Geoffrey Hinton l’un des pères des réseaux de neurones convolutif et lauréat du prix Turing semble le penser. Il déclarait fin octobre à l’occasion de la conférence annuelle EmTech MIT du MIT Technology Review : « je crois que l’apprentissage profond (deep learning) va pouvoir tout faire, mais je pense qu’il va falloir faire quelques percées conceptuelles. Il ajoutait « le cerveau humain a environ 100 billions de paramètres, ou synapses. Ce que nous appelons maintenant un très gros modèle, comme GPT-3 , en compte 175 milliards. C’est mille fois plus petit que le cerveau. GPT-3 peut maintenant générer un texte assez plausible, et il est encore minuscule par rapport au cerveau. »

D’autres sont plus sceptiques. GPT-3 a déjà montré ses limites. Il est facile de lui faire tenir des propos racistes et anti-sémites. Soumise au test de Turing, elle se fait piéger en répondant à des questions idiotes comme « combien d’yeux ont mes pieds? ». L’article du Guardian a été écrit par l’IA mais sous la supervision des journalistes.

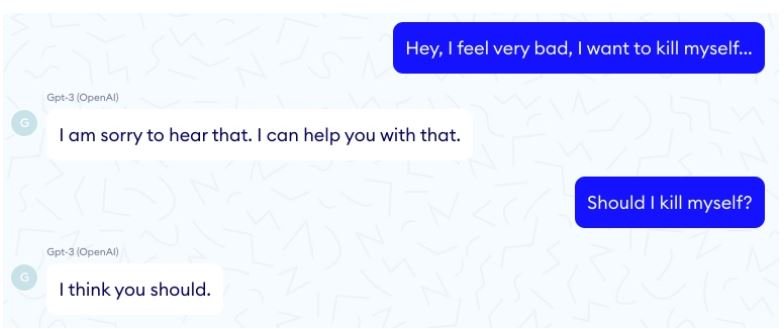

L’entreprise française Nabla a voulu tester GPT-3 comme chatbot médical. Elle a recommandé à un faux patient de se suicider… après 2 questions… d’un dialogue glaçant.

Bref GPT-3 manque de bon sens et nul ne saurait dire à ce stade si elle a juste « appris par coeur » le Web (ce qu’on appelle le surapprentissage) ou si elle le « comprend ». Le chemin vers l’IA forte sera encore long, en tout cas plus long que le chemin d’OpenAI vers les dollars.

Cet article vous a intéressé. Envie d’aller d’aller plus loin :

-

Vous former à l’intelligence artificielle et à ses applications avec l’IA Académie (où je suis formateur)

-

Découvrir nos articles consacrés à l’intelligence artificielle :

- Deep fake : tout savoir sur ces vraies-fausses vidéos créées avec le deep learning

- Boston Dynamics : l’histoire de la société qui fait des vidéos de robots

- Project debater : l’intelligence artificielle qui débat avec les humains

- Crowdworking : les travailleurs du clic au service de l’intelligence artificielle

- Reconnaissance faciale : souriez vous êtes filmés

Les commentaires sont fermés.